Penulis: Angger Reda Tama, S.Pd., M.Pd.

Assalamu'alaikum Sobat Sahabat-Ilmu, kali ini kita akan membahas tentang robots.txt pada setelan situs web. Mari Sobat, kita simak bersama.

Sobat sahabat-ilmu.com mungkin pernah melihat file bernama "robots.txt" di file domain Anda dan Anda bertanya-tanya apa itu dan apa yang dilakukannya?

Bagian "apa itu" sangat sederhana. Ini adalah file teks biasa dan dasar yang harus berada di direktori pengaturan pencarian. Jika Anda menggunakan blogspot, itu akan ada di direktori blogspot Anda.

Pengertian Robots.txt

Pada dasarnya, robots.txt adalah suatu file yang memberikan instruksi ketat untuk mencari atau merayapi isi blog Anda agar mesin pencari mengindeks tentang halaman mana yang dapat mereka jelajahi dan indeks - dan bagian mana yang tidak dirayapi oleh mesin pencari.

Ketika mesin pencarian menemukan domain baru, mereka membaca petunjuk yang ada pada robots.txt sebelum melakukan hal lain, seperti perayapan. Jika mereka tidak menemukan file robots.txt, bot pencarian beranggapan bahwa Anda ingin setiap halaman dijelajahi dan diindeks. Namun hal itu kurang baik, karena yang dikehendaki adalah perayapan nama blog atau web, artikel , dan link di dalam artikel.

Sekarang Anda mungkin bertanya-tanya "Mengapa saya ingin mesin pencari tidak mengindeks halaman di situs saya?" Itu pertanyaan yang bagus!

Singkatnya, itu karena tidak setiap halaman yang ada di situs Anda harus dihitung sebagai halaman terpisah untuk tujuan pencarian. Lebih lanjut tentang topik ini nanti!

Langkah pertama Anda adalah mengonfirmasi bahwa situs baru Anda memiliki file robots.txt. Anda bisa melakukan ini baik dengan dan membuatnya dengan mudah menggunakan editor teks biasa seperti Notepad.

Catatan: Sangat penting untuk hanya menggunakan editor teks biasa, dan bukan sesuatu seperti Word atau WordPad, yang dapat memasukkan kode tak terlihat ke dalam dokumen Anda yang benar-benar akan mengacaukan semuanya.

Cara Setting Robots.txt pada Blog

Blogger dapat mengoptimalkan file robots.txt mereka dengan menggunakan fasilitas yang ada pada direktori pada blog Anda.

Format file robots.txt cukup sederhana. Baris pertama biasanya memberi nama agen pengguna, yang hanya merupakan nama bot pencarian - misalnya, Googlebot atau Bingbot. Anda juga dapat menggunakan tanda bintang (*) sebagai pengenal wildcard untuk semua bot.

Berikutnya adalah string perintah Allow or Disallow. Ini memberi tahu mesin pencari bagian mana yang harus mereka jelajahi dan indekskan ("Allow") dan bagian mana yang harus mereka abaikan ("Disallow").

Aturan ini memastikan bahwa hanya laman yang ingin diindeks akhir di hasil penelusuran.

Jadi untuk rekap: fungsi robots.txt adalah memberi tahu mesin pencari apa yang harus dilakukan dengan konten / di situs Anda. Tapi apakah itu membantu agar situs Anda terindeks?

Setiap blog yang di-host di blogger memiliki file robots.txt bawaannya yang terlihat seperti ini:

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: http://www.example.com/feeds/posts/default?orderby=UPDATED

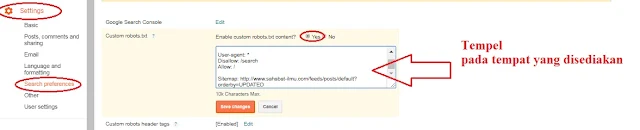

Jika anda ingin menggunakannya salin (copy) dan tempel (paste) pada blog anda seperti gambar berikut. ganti warna merah dengan domain blog Anda.

Langkah-langkah memasang robots.txt pada Blog Anda

1. Login di blogger.com

2. Klik tombol setting >> search preferences >> costum robots.txt >> yes

3. Tempel robots.txt dan ganti tulisan merah dengan domain Anda

4. Kemudia save change

Penjelasan

Kode ini dibagi menjadi tiga bagian. Mari kita pelajari dulu masing-masing bagian yang terdapat pada file robots.txt custom di blogspot blog.

Agen pengguna: Mediapartners-Google

Kode ini untuk robot Google Adsense yang digunakan mereka untuk menampilkan iklan yang lebih baik di blog Anda. Entah Anda menggunakan Google Adsense di blog Anda atau tidak hanya membiarkannya seperti apa adanya.

User - Agent *

Ini untuk semua robot yang ditandai dengan tanda bintang (*). Pada setelan default, tautan label pada Anda dibatasi diindeks oleh perayap penelusuran, berarti perayap pada blog tidak akan mengindeks tautan label pada laman Anda, karena kode Dissallow di bawah ini.

Disallow: / Search

Itu berarti link yang pada kata kunci pencarian hanya setelahtanda / akan diabaikan seperti nama domain sampai label. Lihat contoh berikut ini yang merupakan link dari halaman label bernama SEO.

https://www.contoh.com/search/label/SEO

Dan jika kita menghapus Disallow: / cari dari kode di atas maka crawler akan mengakses keseluruhan blog kita untuk mengindeks dan merangkak semua konten dan halaman webnya. Namun ini berdampak kata kunci penelurusan menjadi kurang optimal.

Disini Allow: / mengacu pada Homepage yang berarti crawler web bisa merayapi dan mengindeks homepage dan posting pada blog kita.

Sitemap: http://www.contoh.com/feeds/posts/default?orderby=UPDATED

Kode di atas berpatokan pada sitemap blog kita. Dengan menambahkan link sitemap di atas kita hanya mengoptimalkan tingkat crawling posting artikel pada blog Anda.

Berarti setiap kali perayap file robots.tx akan menuju pada artikel yang sudah anda postingkan, sehingga mesin pencari akan membaca peta situs kemudian merayapi semua tautan dari pos terbitan pada blog Anda untuk diindeks di mesin pencari..

Oleh karena itu, ada kemungkinan lebih baik perayap web merayapi semua entri blog Anda tanpa mengabaikan satu pun posting artikel yang telah Anda buat.

Catatan: Peta situs ini hanya akan memberi tahu perayap pada blog tentang 25 entri terakhir. Jika Anda ingin meningkatkan jumlah link di sitemap Anda, maka ganti sitemap default dengan dibawah satu. Ini akan bekerja untuk 500 posting terakhir. Tanda merah diganti nama domain blog Anda.

Sitemap: http://www.contoh.com/atom.xml?redirect=false&start-index=500&max-results=1000

Semoga topik pembahasan kali ini dapat membantu Anda dalam mempelajari blog atau web.

Selamat Mencoba